Leseprobe

Abkürzungsverzeichnis 9

Abkürzungsverzeichnis

ADC Analog-Digital-Converter ADDIE Analyse, Design, Development, Implementation, Evaluation AGP Accelerated Graphics Port-Standard ANTL Angewandte Technik mit Labor AV-Daten audiovisuelle Daten BD Blu-ray Disc BK Berufskolleg BKTK Berufskolleg Technische Kommunikation BKTM Berufkolleg Technik und Medien CAD Computer Added Design CAD Computer Aided Design CCD elektronischer Bildwandler (Charge Coupled Device) CMS Content Management System CMYK-Modell Cyan-Magenta-Yellow-Key-Modell CPU Hauptprozessor, (Central Processing Unit) CRMS Course Management System CS2 Adobe Creative Suite 2 CSS Cascading Style Sheets CT Computertechnik DAC Digital-Analog-Converter dpi dots per inch DSL Digitale Teilnehmeranschlussleitung (Digital Subscriber Line) DSP Digital-Signal-Prozessor DV Digital Video

Abkürzungsverzeichnis 10

DVD Digital Versatile Disc DVI Digital Visual Interface DXF Drawing Exchange Format DXF Drawing Exchange Format EPS Encapsulated PostScript EPS Encapsulated Postscript FBAS Farb-Bildsignal-Austastsignal-Synchronisationssignal GMT Gestaltungs- und Medientechnik GPU Grafikprozessor, (Graphics Processing Unit) GSR Gewerbeschule Rastatt HDTV Hochauflösendes Fernsehen (High Definition Television) HiFi hohe Klangtreue (High Fidelity) HTML Hypertext Markup Language IR Infra Rot (infrared) JPEG Joint Photographic Expert Group KD Kommunikationsdesign LCD Flüssigkristallanzeige (Liquid Crystal Display) LE linearer Schnitt (linear editing) LIS Landesinstitut für Schulentwicklung LMS Learning Management System lx Lux (Einheit für Lichtstärke) LZW Lempel-Ziv-Welch MPEG Moving Picture Experts Group NLE nicht linearer Schnitt (non linear editing) ODBC Open DataBase Connectivity OS Betriebssystem (operating system) PAL Phase Alternating Line

Abkürzungsverzeichnis 11

PCI Peripheral Component Interface PCM-Verfahren Puls-Code-Modulations-Verfahren PHP Hypertext Preprocessor Pixel Picture Element ppi pixel per inch PS Postscript RGB-Modell Rot-Grün-Blau Modell RLE Run Length Encoding SCSI Small Computer System Interface SD-Card Sichere digitale Speicherkarte (Secure Digital Memory Card) SGI Silicon Graphics Incorporated SPDIF Sony/Philips Digital Interface SSE2 Streaming SIMD Extensions 2 STL Stereolithography SUM Software und Medientechnik SVGA Super Video Grafics Array SVHS Super Video Home System S-Video Separate Video TDok Technische Dokumentation TFT Dünnschichttransistor (thin-film transistor) TG Technisches Gymnasium TGG TG Profil „Gestaltung und Medien“ USB Universal Serial Bus VGA Video Graphics Array VHS Video Home System VLE Virtual Learning Environment WLAN Wireless Local Area Network

Abkürzungsverzeichnis 12

WYSIWYG What You See Is What You Get XGA Extended Graphics Array Y/C siehe S-Video

Vorwort 13

Vorwort

Die vorliegende Arbeit entstand im Rahmen meines Masterstudium “Informatik und Multimedia“ an der Hochschule Karlsruhe in Zusammenarbeit mit der Gewerbeschule Rastatt.

Die Gewerbeschule Rastatt bietet eine sehr weit gefächerte Ausbildung im Bereich Medientechnik und Gestaltung an. Durch einen tragischen Unfall des Lehrers für Medientechnik, gleichzeitig die Hauptperson im Bereich „Multimedia-Technik“, verwaiste der Bereich und ein vor langer Zeit geplantes, von jeder Seite gewünschtes Medienlabor wurde nicht verwirklicht. Diese Arbeit befasst sich mit der Konzeption und der praktischen Umsetzung des dringend benötigten Medienlabors.

Zunächst möchte ich mich bei Herrn OStD Wendelgaß und Herrn Prof. Dr. Hoffmann für die unkomplizierte und sehr effiziente Zusammenarbeit bedanken. Sie haben die notwendigen Rahmenbedingungen geschaffen und hatten während der ganzen Zeit immer ein offenes Ohr für die nicht wenigen Probleme. Ebenfalls möchte ich mich bei Herrn Steffen Veigel bedanken, der mich durch viel Engagement und konstruktive Gespräche unterstützt hat. Weiterhin möchte ich allen Lehrern, Mitarbeitern und Schülern der Gewerbe- schule Rastatt danken, die mir durch ihre Ratschläge weitergeholfen haben.

1 Kurzfassung 14

1 Kurzfassung

1 Kurzfassung 15

Vergleich der Labor Soft- und Hardware). Konstruktiv auf den Lö- sungsvorschlag wird die Anpassung und Überprüfung der Skalierbarkeit der Konzepte an spätere Änderung der Aufgaben und Lehrpläne durchgeführt werden. (siehe Kapitel 7 - 9) Phase 5: Für den praktischen Aufbau des Labors werden die vorhandenen Mittel auf deren Aktualität geprüft, ebenso welche Technologien sich in diesem Bereich derzeit auf dem Markt befinden und was ihre spezifischen Vor- und Nachteile sind. Für den Aufbau sollen auch die Anbindung an das Schulnetzwerk und das pädagogische Netzwerk gegeben sein. (siehe Kapitel 10 und 11) Für zukünftige Änderungen und Anpassungen wird geprüft werden, ob man Sponsoren finden oder Fördergelder (Land/Bund/EU) beantragen kann.

2 Einleitung 16

2 Einleitung

Für die Planung und Realisierung des Medienlabors an der Gewerbeschule Rastatt sollen alle wesentlichen Faktoren gefunden werden. Dies fordert ein umfassendes Vorgehen, in welchen Kontexten sich eine nachhaltige Entwicklung der neuen Medien ergeben und welche Perspektiven daraus entstehen können. Eine thematische Einschränkung, die sich nur auf die Informatik und Medientechnik als Wissenschaft bezieht, vernachlässigt andere wichtige Einflussgrößen. Eine Einbeziehung der Medienpädagogik soll helfen, Fragestellungen in Bezug auf die verschiedenen Lerntheorien zu erörtern. Daraus ergeben sich Wechselwirkungen, die im Hinblick auf die Integration von Soft- und Hardware relevant sind.

Der Lösungsansatz beruht einerseits auf der wissenschaftlichen Literaturauswertung und einer vergleichenden Stellungnahme der technischen Möglichkeiten, andererseits werden empirische Erhebungen in Form von Fragebogen, Interviews und Arbeitsproben verwendet mit dem Zweck, den zielorientierten Bedarf zu ermitteln. Dabei stehen die finanziellen Mittel weit im Vordergrund und es muss bei Neuanschaffungen auf kostengünstige oder Open-Source Lösungen gesetzt werden.

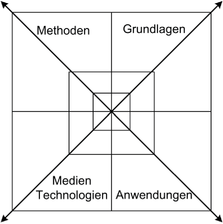

Mit der Gestaltung eines Medienlabors sollen geeignete Lernbedingungen für die Arbeit mit multimedialen Aufgaben geschaffen werden. Dies geschieht im Spannungsfeld von Inhalt, Methode (Didaktik), Eigenschaften verfügbarer Medien und Technologien sowie den Voraussetzungen, die der Lehrer/Schüler selbst mitbringt.

Die Perspektive, die dabei auf das Medienlabor eingenommen hinzielt und wie diese interpretiert wird, hängt von dem jeweiligen lerntheoretischen Hintergrund ab.

Es gibt im Wesentlichen vier Faktoren, die zur Beschreibung des Medienlabors gehören: x der Inhalt (Regeln, Begriffe etc.) des Lernangebots und die zugehörige Methodik der Darbietung (Methode),

2 Einleitung 17 x die technische Basis auf der Grundlage der aktuellen Technologien und Medien, die zum Einsatz kommen (Technologien), x die konkrete Gestaltung der Anwendungen die im schulischen Kontext eingebettet sein sollten (für soziale, räumliche und zeitliche Situationen bestimmt), x die Voraussetzungen der Schüler, die Vorwissen, Lernmotivation, Lerngewohnheiten und Medienkompetenz mit in den Unterricht einbringen (Grundlagen). Diese Faktoren müssen als ein System gesehen werden, die sich gegenseitig beeinflussen und sollten aufeinander abgestimmt sein. Ändern sich Lernziele oder Lernangebote, dann könnte dies auch für eine Veränderung der didaktischen Methode sprechen.

Bei der Entwicklung des Medienlabors wird das klassische Designmodell „AD- (Analyse, Design, Development, Implementation, Evaluation)[Gustafson02] angewendet.

3 Ziele 18

3 Ziele

Ziel dieser Arbeit ist es, ein Medienlabor an der Gewerbeschule Rastatt zu kon- zu evaluieren und praktisch umzusetzen. Dabei ist der gegenwärtige Stand der Technik zu berücksichtigen und mit den vorhandenen Mitteln abzustimmen. Es sollen multimediale Lerninhalte praktisch vermittelt werden, damit dieses praktisch erworbene Wissen im Unterricht theoretisch gefestigt werden kann. Dadurch sollen die Schüler, aber auch die Lehrkräfte, sicherer im Umgang mit den neuen Medien werden.

Durch die technische Voraussetzung mit einem Medienlabor soll neben der Technik auch die Vermittlung von Medienkompetenz auf didaktischen-, methodischen Ansätzen möglich sein.

3.1 Medienkompetenz

Angesichts der Allgegenwart von Medien in der modernen Lebens- und Arbeitswelt wird gerade von jungen Menschen, die ihren Schulabschluss erfolgreich hinter sich gebracht haben, erwartet, dass sie ein hinreichendes Maß an „Medienkompetenz“ besitzen. Für immer mehr Berufe gilt Medienkompetenz heute schon als Schlüsselqualifikation, die bei den Bewerbungen der Schüler entsprechend nachgefragt wird. Die Grundannahme ist, dass Medienkompetenz nicht durch die übliche Form des Unterrichts erworben wird, indem man über die Medien spricht, sondern indem man damit und daran arbeitet. Mit dem Medienlabor kann man aktiv praktische Medienkompetenz, für den wichtigen audiovisuellen Bereich, vermitteln. Vermittlungsziele sind: [Baacke97] x Fähigkeit zur aktiven Kommunikation Erlernen und Anwenden spezifischer Ausdrucks- und Gestaltungsmöglichkeiten und journalistischer Methoden; Fähigkeit zur aktiven Kommunikation mit audiovisuellen Medien von der Planung und Recherche über die Produktion und Gestaltung bis zur Fähigkeit der Verbreitung eigener audiovisueller Erzeugnisse. x Kenntnis der technischen und organisatorischen Bedingungen

3 Ziele 19

Fähigkeit im Umgang mit den technischen (Kamera, Ton, Licht, Schnitt, Nachvertonung, Ausstrahlung von Beiträgen) und den organisatorischen Bedingungen, von der schriftlichen Fixierung bis zur Öffentlichkeitsarbeit und der Organisation zur Verbreitung der eigenen Medienprodukte. x Kompetente Rezeption Sensibilisierung der eigenen Wahrnehmung und Fähigkeit zur Filterung und kompetenten Analyse audiovisueller Informationen mit dem Vorsatz der kritischen und emotional distanzierten Wahrnehmung; Vermittlung von Format- und Genrewissen.

3.2 Didaktische, methodische Ansätze

Ziel ist es auch, die didaktischen-, methodischen Ansätze zusammen mit der notwendigen Technik an bestehende Anforderungen und Aufgabenstellungen anzupassen, um auf neue Randbedingungen reagieren zu können.

4 Grundlagen Technik 20

4 Grundlagen Technik

Um mit den Gerätschaften und den Konzepten der Medienproduktion zurecht- ist es unerlässlich, auch Basiswissen im Bereich Multimedia Technik mitzubringen. Wichtig ist die Vermittlung von möglichst zeitüberdauernden technologischen Grundlagen und darauf aufbauendem Spezialwissen. In diesem Kapitel sollen die Grundlagen für Medienarbeiten im Labor erläutert werden.

4.1 Audio

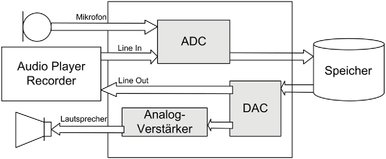

In der Anwendung wird für die Audio-Bearbeitung vor allem analoges Grundmaterial von analogen Datenträgern zur Verfügung stehen oder digitales Grundmaterial auf Datenträgern bzw. direkt importiertes Audio-Datenmaterial, das durch einen Analog/Digital-Wandler digital vorliegt. Die Digitalisierung erfolgt meist durch das PCM-Verfahren (Puls-Code-Modulations-Verfahren). Dabei wird das analoge Ursprungssignal mit einer Abtastfrequenz ausgemessen und generiert daraus Abtastwerte (Samples). Dabei ist zu beachten, dass die Abtastrate mindest doppelt so groß als die abzutastende Frequenz sein sollte. Dies ergibt sich aus dem Nyquist-Abtasttheorem. Die entstandenen Abtastwerte werden durch eine Auflösung repräsentiert. Diese Auflösung hängt davon ab, wie viele Bits pro Messung verwendet werden. Typisch für eine Audio Compact Disk sind 44,1kHz Abtastfrequenz und 16Bit Auflösung [Henning03]. Der Mechanismus, der ein Audiosignal in eine Folge digitaler Samples umwandelt, wird als Analog-Digital-Konverter (ADC) bezeichnet. Die umgekehrte Umwandlung wird durch ein Digital-Analog-Konverter (DAC) vollzogen. [Steinmetz00]

Die so gewonnenen Audio-Daten können nun mit Hard- und Software weiter verarbeitet und aufbereitet werden. Je nach Anwendung werden die Daten komprimiert oder nachbearbeitet. Diese Anwendungen stellt das jeweilige Soft- wareprodukt zur Verfügung und hängt auch von der benutzten Hardware ab.

4 Grundlagen Technik 21

Um die Audiosignale - wie oben beschrieben - importieren, digitalisieren und wiedergeben zu können, werden Schnittstellen benötigt, die die Ein- und Ausgabe ermöglichen. Bei Audio verwendet man vor allem eine Soundkarte, Lautsprecher, Mikrofon und die Ein- und Ausgabe auf Speichermedien wie CD, USB-Sticks (Universal Serial Bus), o.ä.. Zu der jeweiligen Schnittstelle muss natürlich auch die passende Software vorhanden sein.

Abbildung 2: Soundkarte

4 Grundlagen Technik 22

Ein- und Ausgänge existieren in unterschiedlichen Ausführungen; es gibt ana- Ein-/Ausgänge in verschiedensten Formen. Qualitativ unterscheiden sich die ADC-/DAC-Konverter durch die mögliche Bit-Auflösung und Bit-Wortbreite, maximale Abtastrate, Rauschverhalten, Frequenzgang und der maximalen Anzahl der Kanäle.

Zudem unterstützen viele Soundkarten verschiedene Soundausgabecodes, die auch von einigen Software-Produkten unterstützt werden. Normale Soundkarten verfügen oft - im Gegensatz zu den Onboard-Varianten - über einen Digital-Signal-Prozessor (DSP), welcher zum Digitalisieren und Weiterverarbeiten von Audiosignalen dient und der CPU (Central Prozessing Unit) Rechenleistung abnimmt. [Wiki06]

x Frequenzgang: Kennzeichnet den Übertragungsbereich und ist ein Maß für lineare Verzerrungen. Entscheidend ist die Linearität des Frequenzbereiches innerhalb der erwünschten Bandbreite. x Eingangsspannung am Mikrofoneingang: Kennzeichnet die Eingangsempfindlichkeit bei Anschluss eines Mikrofons. x Abtastfrequenz: Diese bestimmt, wie oft ein Signal pro Sekunde abge- tastet wird.

4 Grundlagen Technik 23 x Signalauflösung: Bestimmt, mit welcher Genauigkeit das abgetastete Signal digital aufgelöst wird.

4.1.2 Lautsprecher

Die akustische Ausgabe wird meist über externe Lautsprecher oder Kopfhörer ausgegeben. Die Schallwellen werden durch niederfrequente elektrische Schwingungen in hörbare mechanische Schwingungen umgewandelt. Diese Schwingungen werden auf eine Membran übertragen und erzeugen Luftschwingungen, die wir als Schall hören.

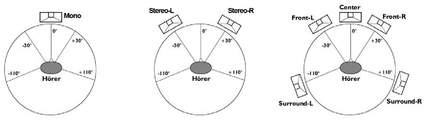

Der Lautsprecher ist das schwächste Glied in der Kette der Audiobearbeitung. Deshalb muss der Lautsprecher oder das Lautsprechersystem direkt an die vorherrschenden Anforderungen angepasst und eingerichtet werden. Wesentliche Grundmerkmale sind: x Frequenzgang: Gibt an, welche Ausgangspegel bei verschiedenen Frequenzen abgegeben werden. Der ideale Lautsprecher hätte ein nahezu lineares Frequenzdiagramm. x Klirrfaktor: Gibt an, welche Abweichung zu dem auszusendenden Tonsignal besteht. Der Klirrfaktor sollte maximal 1% betragen. x Wirkungsgrad: Gibt an, welche Lautstärke bei einer fest eingestellten Leistung abgegeben wird. Der Wirkungsgrad wird in dB-W/m gemessen. x Impedanz: Gibt den Innenwiderstand des Lautsprechers an. Dieser Wert liegt üblicherweise zwischen 4 und 8 Ohm. Um die größtmögliche Leistung an dem Lautsprecher zu erzielen, sollte die Impedanz des Verstärkers und der Lautsprecher identisch sein. x Sinusbelastbarkeit: Gibt die Dauerbelastung der Lautsprecher an, ohne dass es zu Schäden kommt. x Musikbelastbarkeit: Gibt die kurzzeitige Belastung an; bei längerer Belastung kann es zu Beschädigungen der Lautsprecher führen. Aufstellung (Systeme): Da es verschiedenste Anwendungen für Lautsprecher gibt, gibt es auch unterschiedliche Lautsprechersysteme. Um eine Stimme - wie beim Telefon - zu übertragen, reicht ein Kanal (Mono) mit einem Lautsprecher aus. Um hochwertige HiFi-Musik zu übertragen, braucht man zwei Lautsprecher

4 Grundlagen Technik 24

(Stereo). Um einen Raumklang zu erzeugen, werden mit Dolby-Surround min- fünf Lautsprecher benötigt, deren Anzahl kann bis zu acht Lautsprechern betragen. Die Aufstellung hängt von dem jeweiligen Lautsprechersystem ab.

4.1.3 Mikrofon

Sprache, Gesang, Töne oder Geräusche werden mit Hilfe von Mikrofonen aufgenommen, die ankommende Schallwellen in elektrischen Strom umwandeln. Man spricht hier vom Prinzip der elektro-akustischen Wandlung. Verwendung finden hauptsächlich zwei Arten von Mikrofonen, die nach ihrem Aufbau- und Funktionsprinzip unterschieden werden können: Dynamische Mikrofone arbeiten nach dem Tauchspulenprinzip. Eine Membran, die von Schallwellen in Bewegung gesetzt werden kann, ist mit einer Spule verbunden, die in das ringförmige Magnetfeld eines starken Dauermagneten eintaucht. Wird die Spule von den Schallwellen im Magnetfeld bewegt, wird eine dem Schalldruck proportionale Spannung induziert. Dieser Spannungsverlauf entspricht dem Verlauf der Schallwellen und kann direkt als elektrisches Audiosignal an einen Verstärker oder einen ADC geführt werden. Durch die Bauweise können sehr hohe Schalldrücke verzerrungsfrei wiedergegeben werden. Dynamische Mikrofone sind sehr robust und benötigen keine Versorgungsspannung; allerdings weist das Mikrofon einen nicht linearen Frequenzgang und ein schlechtes Impulsverhalten auf, das durch das hohe Gewicht der Membran und Spule verursacht wird. [Steinmetz00]

Kondensator-Mikrofone benutzen zur Schallwandlung einen veränderlichen Plattenkondensator. Als Membran dient eine dünne Folie, die zugleich auch die

4 Grundlagen Technik 25

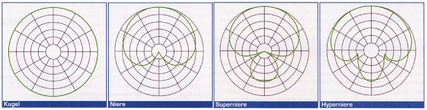

vordere Elektrode des Kondensators ist. Treffen Schallwellen auf die Membran, verändert sich die Kapazität des Kondensators und es entsteht eine Wechselspannung, die proportional dem akustischen Signal abgenommen werden kann. Da der Kondensator geladen werden muss, benötigen diese Mikrofone eine externe Spannung, welche über das Kabel oder per Batterie bereitgestellt werden kann. Das Kondensator-Mikrofon besitzt ein sehr gutes Impulsverhalten und einen relativ linearen Frequenzgang. Dadurch haben Kondensator-Mikrofone im hohen Frequenzgang ein sehr klares Klangbild. Die Bauweise ist aufwendiger und empfindlicher als bei dynamischen Mikrofonen. Beide Mikrofonarten haben als wichtiges Merkmal die Richtcharakteristik. Sie gibt an, aus welcher Richtung das Mikrofon den Schall am empfindlichsten aufnimmt. Bekannteste Richtcharakteristiken sind Kugel, Niere, Superniere und Hyperniere. [Jungwirt04]

4.2 Video

Unter Video soll im Folgenden - aufbauend auf den Einzel-Bildern - die Bildtechnik und die Grundlagen zu den Bewegt-Bildern erörtert werden.

4.2.1 Farbräume

Das menschliche Auge wandelt elektromagnetische Strahlung einer bestimmten Wellenlänge in eine vom menschlichen Gehirn verständliche Information um. Diese Informationen werden über Photorezeptoren aufgenommen und an das Gehirn weitergeleitet. Das Gehirn ordnet dieser Information den Sinneseindruck

4 Grundlagen Technik 26

Farbe oder Helligkeit zu. Das für den Menschen sichtbare Spektrum dieser Strahlung liegt im Wellenlängenbereich von 400nm bis 700nm. Es gibt zwei verschiedene Photorezeptoren auf unserer Netzhaut, die jeweils bestimmten Wellenlängenbereichen zugeordnet sind. Stäbchen sind für die Helligkeitsempfindung verantwortlich und konzentrieren sich in der Peripherie der Netzhaut. Zäpfchen sind für die Farbempfindung verantwortlich und konzentrieren sich im Zentrum der Netzhaut. Die Farbempfindung wird durch die Empfindlichkeit der Zäpfchen wahrgenommen. Die jeweils größte Empfindlichkeit der Zäpfchentypen liegt dabei bei etwa 580nm, 545nm und 440nm:

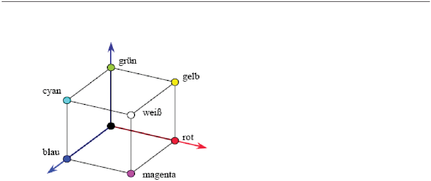

• 4% Blau, 440 nm, • 32% Grün, 545 nm, • 64% Rot, 580 nm [Henning03] Es genügen drei Zahlenwerte für die quantitative Beschreibung von Farben. Um Farbe in Multimediasystemen einsetzen zu können, muss jeder Farbe ein eindeutiger Wert zugeordnet werden; erst dann können Farben identifiziert und unterschieden werden. Da das menschliche Auge drei Arten von farbempfindlichen Zäpfchen enthält, entwickelte sich die Dreifachtheorie. Nach dieser können alle sichtbaren Farben aus genau drei Primärfarben zusammengemischt werden. Bedingung für eine Primärfarbe ist, dass sich keine der Primärfarben aus den anderen beiden zusammenmischen lässt. Das Mischen der Farbe wird unterschieden in

- additive Farbmischung: dabei werden drei „Lichtfarben“ additiv gemischt, wodurch die Endfarbe immer heller wird;

- subtraktive Farbmischung: dabei werden drei „Körperfarben“ subtraktiv gemischt, wodurch die Endfarbe dunkler wird.

4 Grundlagen Technik 27

Das RGB-Modell wird für die Farbdarstellung auf Bildschirmen verwendet und orientiert sich an der Hardware. Unterschiedliche Bildschirme und andere Ausgabegeräte können dabei unterschiedliche Farbwerte liefern.

4 Grundlagen Technik 28

4.2.1.3 Das YUV-Farbmodell

Das YUV-Farbmodell wird in der Fernseh-/Videotechnik zur Steigerung der Ü- bertragungseffizienz und zur Abwärtskompatibilität mit dem Schwarzweiß- Fernsehen verwendet. Das Signal ist zusammengesetzt aus einem Luminanzsignal Y (Helligkeitsinformation) und zwei Chrominanzsignalen U bzw. CB und V bzw. CR. Das Auge besitzt mehr Rezeptoren für Helligkeitswerte als für Farbwerte, wodurch die Farbinformationen mit weniger Bandbreite übertragen werden können und das Luminanzsignal für den Detail-Eindruck wichtiger ist als die Farbsignale und deshalb mehr Bandbreite erhält.

Y U V

4.2.2.1 Bitmap-Grafiken (Raster-Grafiken)

Eine Bitmap-Grafik wird über ein Raster, das die Bildpunkte pro Zeile angibt, definiert. Die Anzahl der Bildpunkte auf einer bestimmten Fläche wird auch Auflösung genannt. Gängige Einheiten sind ppi (pixel per inch) oder dpi (dots per inch). Die Auflösung muss an das jeweilige Ausgabemedium angepasst werden, damit die Grafik ausreichend gut dargestellt werden kann (z. B. Bildschirmausgabe mindestens 72 dpi). Jedes Pixel besitzt eine Farbwertigkeit. Die möglichen Farbwerte werden in der Farbtiefe festgelegt. Bei z. B. 1Bit Farbtiefe können 2 Farben dargestellt werden. Gängige Farbtiefe bei Monitoren sind 24 Bit und somit sind 16,7 Millionen Farben pro Pixel möglich.

4 Grundlagen Technik 29

Da bei Bitmap-Grafiken sehr große Datenmengen anfallen können, wurden ver- Komprimierungsverfahren entwickelt, um das Datenvolumen an die jeweilige Anwendung anzupassen. Bei den Kompressionsverfahren unterscheidet man zwischen nicht verlustbehafteter und verlustbehafteter Kompressionsmethoden. Diese Methoden werden in den Grafikformaten hinterlegt. Gebräuchliche nicht verlustbehaftete Kompressionsverfahren sind RLE (Run-Length-Encoding), LZW (Lempel-Ziv-Welch) und Huffmann-Encoding. Für verlustbehaftete Kompressionsverfahren stehen unter anderem JPEG (Joint Photographic Expert Group), Fraktale Kompression und Wavelet-Kompression. [Schellmann02]

4.2.2.2 Vektorgrafiken

Vektorgrafiken werden auch als objektorientierte Grafiken bezeichnet und bestehen aus mathematisch exakt definierten Kurven und Linien. Durch erneute Berechnung der Kurven sind die Dateien ohne Verlust skalierbar und können an jedes Format, ohne Vorgabe der Auflösung, angepasst werden. Gespeichert werden nur die mathematischen Daten, nicht wie bei Bitmapgrafiken die einzelnen Pixel, wodurch Vektorgrafiken weniger Speicherplatz benötigen. Vektorgrafiken sind ideal zur Speicherung von Bildern, die in linienbasierte Informationen zu überführen aber nicht geeignet sind für komplexe Bilder wie Fotos mit pixelweise wechselnden Farben. Gebräuchliche Vektorgrafikformate sind Postscript (PS), Encapsulated Postscript (EPS) und Drawing Exchange Format (DXF).

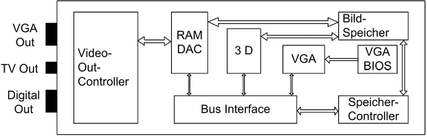

4.2.3 Die Grafikkarte

Die Grafikkarte ist das Bindeglied zwischen der binären Computerwelt und unserer visuellen Wahrnehmung. Über die Bus-Schnittstelle erhält sie die zur Anzeige benötigten Daten. Diese werden im Videospeicher der Karte abgelegt, vom Grafikprozessor weiter berechnet bzw. gerendert und anschließend von einem Digital-Analog-Wandler (RAM-DAC) in ein analoges Bildsignal umgerechnet. Grafikkarten werden entweder als PC-Erweiterungskarten mit der Hauptplatine verbunden oder sie sind im Chipsatz auf der Hauptplatine vorhanden (Onboard). Das System sendet Informationen und Daten, die dargestelltwerden sollen, über die Bus-Schnittstelle an die Grafikkarte.

4 Grundlagen Technik 30

Die Bus-Systeme unterscheiden sich in der Geschwindigkeit und Art der Über- der Grafikdaten. Aktuelle Bus-Systeme sind: PCI, AGP und PCI-Express. Der derzeitige AGP-Standard (Accelerated Graphics Port-Standard) wird nach und nach von der modernen PCI-Express-Schnittstelle (Peripheral Component Interface Express) abgelöst.

Für alle grafikrelevanten Berechnungen ist der Grafikprozessor (GPU) verantwortlich, der sowohl das Berechnen von zweidimensionalen Darstellungen als auch das Rendern von dreidimensionalen Bildern übernimmt. Dem Grafikprozessor obliegen rechenintensive Aufgaben und er entlastet dadurch den Hauptprozessor (CPU). Im VideoRAM werden Bildelemente in einzelne Bildpunkte zerlegt und gespeichert. Die VideoRAM-Speicher (auch Framebuffer) wurden speziell für Grafikanwendungen konzipiert und verkürzen die Zugriffszeiten. Die Größe des Speichers beeinflusst unter anderem die maximal darstellbare Farbtiefe und Auflösung. Der RAM-Digital-Analog-Converter (RAMDAC) wandelt das digitale Ausgangssignal in ein analoges Signal um, welches auf dem Monitor ausgegeben wird. Die Leistungsfähigkeit wird in der Pixelfrequenz, die Anzahl der Pixel, die der RAMDAC pro Sekunde umwandeln kann (MHz), angegeben; je höher die Rate, desto höher kann die Auflösung bzw. die Bildwiederholfrequenz eingestellt werden. [Steinmetz02]

Je nach Ausstattung der Karte sind ein oder mehrere analoge oder digitale Ausgänge vorhanden, um das Bild extern darstellen zu können. Mögliche Ausgänge sind: Video Graphics Array (VGA), Separate Video (S-Video, TV out) und Digital Visual Interface (DVI).

4 Grundlagen Technik 31

4.3 Camcorder

Für die Aufnahme stehen analoge und digitale Camcorder zur Verfügung. Bei analogen Camcordern muss das Filmmaterial für die spätere Weiterverarbeitung digitalisiert werden. Für die Digitalisierung muss aufwendige Hardware vorhanden sein und der Arbeitsaufwand ist hoch. Bei digitalen Camcordern liegt das Filmmaterial bereits digitalisiert vor, dieses muss nur noch über eine geeignete Schnittstelle zu dem Schnittrechner übertragen werden. Für die Tonaufnahme haben die meisten Camcorder ein Mikrofon integriert; oft ist es aber vorteilhafter ein externes Mikrofon zu benutzen, um die Akustik optimal auszunutzen (siehe Kapitel 4.1.3).

4.3.1 Optik

Unter Optik versteht man den Bereich des Camcorders, in welchem das Licht in das Gehäuse trifft. Die Optik muss lichtstark sein, ansonsten kann man in dunklen Räumen gar nicht oder nur in schlechter Qualität filmen. Die Lichtstärke der Optik gibt an, wie viel Licht das Objektiv bei voller Öffnung der Blende passieren lässt; je größer der Linsendurchmesser umso größer die Lichtstärke. [Schmidts03]

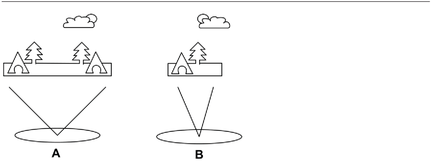

4.3.2 Brennweite

Der Abstand, in dem sich parallel eintreffende Lichtstrahlen in einem Punkt der Abbildungsfläche treffen, nennt man Brennweite. Bei kleiner Brennweite spricht man von einem Weitwinkel-Objektiv, bei großer Brennweite von einem Zoom-Objektiv.

Der Bildwinkel beschreibt den Winkelbereich, den ein Objektiv auf dem Bildwandler, Charge Coupled Device (CCD), abbilden kann. Der Bildwinkel wird in Grad angegeben. Im Objektiv, das einen Bildwinkel von 60 Grad besitzt, werden alle Objekte abgebildet, die sich zwischen 30 Grad links und 30 Grad rechts des Camcorders befinden. Eine kleine Brennweite entspricht einem gro- ßen Bildwinkel und umgekehrt. [Schmidts03]

4 Grundlagen Technik 32

4.3.3 Blende

Die Blende bestimmt, wie viel Licht durch das Objektiv auf das CCD fallen kann. Die Öffnung wird in seiner Größe verändert, wobei ein großer Blendenwert immer eine kleine Blendenöffnung und umgekehrt bedeuten. Die Verschlusszeit ist bei Camcordern meist auf 1/25 Sekunde limitiert, wodurch der Lichteinfall fast ausschließlich durch die Blende gesteuert wird. Über die Verschlusszeit wird bestimmt, wie lange Licht auf das CCD geworfen wird; dabei kann die Verschlusszeit nicht größer als 1/25 Sekunde sein, da Video 25 Bilder pro Sekunde aufzeichnet. Kürzere Verschlusszeiten verbessern die Schärfe von bewegten Objekten, es reduziert die Bewegungsunschärfe. [Schmidts03]

4.3.4 Der Bildwandler (CCD)

Das Licht, das durch die Optik auf den Bildwandler auftrifft, wird in analoge Ströme umgewandelt.

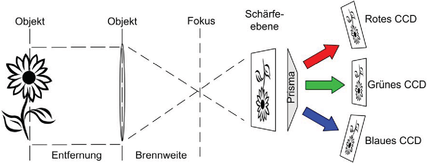

Der CCD besteht aus lichtempfindlichen Zellen, die auf Helligkeit reagieren. Die Anzahl der Zellen wird mit der Pixelzahl des CCDs definiert. Trifft das Licht auf den CCD, wird das Bild in Pixel zerlegt. Je mehr Pixel ein CCD besitzt, desto mehr Details eines Bildes kann dieser aufzeichnen. Man unterscheidet bei Camcordern zwischen zwei Gerätetypen, den Ein-Chip-CCD- und den Drei-Chip-CCD-Modellen. Bei Camcordern mit einem CCD müssen die drei Grundfarben auf einem Chip erzeugt werden. Der CCD-Chip kann nur Helligkeitsunterschiede aufzeichnen, Farbinformationen müssen durch Farbfilter vor den Zellen über eine Farbmatrix herausgefiltert werden. Dabei

4 Grundlagen Technik 33

liefert jedes Pixel nur einen Farbwert und keine exakten Helligkeitsinformatio- mehr. Die RGB-Farbinformationen werden durch mehrere nebeneinander liegende Pixel errechnet. Dabei gehen Farbinformationen verloren, da jedes Pixel nur einen Teil der RGB-Farbinformation liefert. [Schmidts03] Bei einem Drei-Chip-Camcorder wird das Licht über ein Prisma in die Grundfarben zerlegt, die jeweils auf einen separaten CCD treffen. Der CCD nimmt nur die Helligkeitsinformationen einer Grundfarbe (RGB) auf. Werden diese Daten später zusammengerechnet, ergibt sich ein Pixel mit exaktem RGB-Wert. Man erhält ein Bild ohne Verluste im Farbraum. [Schmidt03]

4.3.5 Auflösung

Die gängigen Camcorder arbeiten mit einer Auflösung nach dem PAL-Standard (Phase Alternating Line-Standard) mit 720x576 Pixel. Hierfür wäre ein CCD mit 414.720 Pixel ausreichend. Bei einem Drei-Chip-Camcorder müssten drei Chips für RGB mit der gleichen Auflösung eingebaut sein. Um in HDTV-Auflösung zu filmen muss mindestens eine Pixeldiche von 520.000 Pixel pro CCD vorhanden sein. Bei Camcordern mit mehr als 420.000 Pixel pro Chip werden andere Technologien hinzugefügt. Für den Bildstabilisator, höhere Auflösungen oder andere Bildformate wird eine höhere Pixeldichte benötigt.

4.3.6 Audio

Camcorder sind mit einem der drei Audioformaten erhältlich: Mono, Stereo und PCM-Stereo. Mono zeichnet nur auf einem Kanal auf, Stereo hingegen auf zwei

4 Grundlagen Technik 34

Kanälen. PCM-Stereo ist ein digitaler Standard und kann viel mehr Klanginfor- aufzeichnen als Mono oder Stereo.

4.3.7 Speichermedien

Als Speichermedien für Camcorder haben sich Kassetten oder DVDs (Digital Versatile Disc) etabliert.

Der Camcorder schreibt die Videodaten im DV-Format auf Kassette, das besonders viele Details speichert. Die professionellen DV-Systeme (DVCPRO und DVCAM) unterscheiden sich durch die Kassettengröße zu den herkömmlichen Mini-DV-Geräten. Die Kameras verwenden höher auflösende Bildsensoren. Bei DV ist die Spurbreite, mit der auf das Band aufgezeichnet wird, 10µm. Damit können auf eine DV-Kassette - je nach Typ - 60 bis 80 Minuten aufgezeichnet werden. Beim konkurrierenden DVCAM-System beträgt die Spurbreite 15µm, bei DVCPRO und DVCPRO-50 sogar 18µm. Es wird mehr Magnetband-Fläche zur Aufzeichnung benötigt, daher fasst eine Kassette - je nach System - auch nur 33 bis 45 Minuten und die Sicherheit gegenüber Störsignalen ist dadurch höher. Um Filmdaten auf das Schnittsystem zu übertragen, muss die Sequenz in Echtzeit durchlaufen, um kopiert zu werden. [Schmidts03] Camcorder mit DVD-Medium speichern die Aufnahmen als Dateien ab, die sich auf den Rechner übertragen lassen. Diese DVD-Medien können direkt in einem externen DVD-Player als Quelle eingesetzt werden. Als Speicherformat dient das MPEG-2 Format, das die Daten besonders stark komprimiert; als Speichervolumen können ca. 40 Minuten aufgezeichnet werden. [Schmidt03]

4.3.8 Schnittstellen

Das Filmmaterial wird über Schnittstellen, die am Camcorder und an dem Schnittsystem vorhanden sein müssen, übertragen. Bei digitalen Camcordern nutzt man die Firewire-Schnittstelle 1 , über die Daten mit einer Rate von 400 MBit/s übertragen werden können. Oft ist auch eine USB-2.0 Schnittstelle vorhanden. Damit können die Daten mit einer Rate von 480 MBit/s auf das Schnitt-

4 Grundlagen Technik 35

system übertragen werden. Für analoge Datenübertragung stehen S-Video, Composite-Video und Composite-Audio bereit.

4.4.1 Videoschnitt

Im Schnitt werden die richtigen von den unrichtigen Bildern und Tönen getrennt, werden Einzelelemente in einen Zusammenhang gestellt. Der Schneideprozess geschieht durch visuelles Zusammenstellen der Einzelsequenzen, dem Hinzufügen von Effekten und dem synchronen Anlegen der Tonspuren mit der sofortigen Kontrolle des erzeugten Ergebnisses. Dabei werden in einem Zeitkoordinatensystem mit einer definierten Zeitskala die einzelnen Video- und Audiosequenzen in Spuren eingesetzt. Für aufwendige Effekte, Anpassungen oder das Endprodukt muss der Film gerendert werden. [Schellmann02] Man unterscheidet hierbei den linearen Schnitt (LE), den man an einem Maschinenschnittplatz unter Zuhilfenahme mehrerer Abspieler und Rekorder durchführt. Dabei wird ein Fragment nach dem anderen von vielen Quellbändern auf ein Sendeband kopiert, so dass hierbei ein Zwischenprodukt oder ein Sendeband entsteht.

Beim nicht-linearen-Videoschnitt (NLE) wird das Rohmaterial auf einen Computer übertragen und dort in beliebiger Reihenfolge (nicht linear) bearbeitet. Der Computer erstellt das fertige Video beim Rendern. Dadurch lassen sich einfache Korrekturen verschiedenster Art am Video machen. In den gängigen Schnittlösungen stehen jeweils eine Reihe von Effekten zur Verfügung, mit denen das Video verändert und angepasst werden kann. [Schmidts02]

4.4.1.1 Offene nonlineare Schnittsysteme

Ein offenes nonlineares Schnittsystem arbeitet, bis auf die Videoschnittkarte, mit Standardkomponenten und Schnittsoftware. Videoschnittkarte:

Der Hauptanspruch an die Hardware besteht darin, die Videodatenströme schnell genug bereitzustellen. Durch den Einsatz von Standard-PC- Ausstattungen kommen immer günstigere und leistungsfähigere Komponenten

4 Grundlagen Technik 36

zum Einsatz. Die steigende Leistungsfähigkeit elektronischer Bauelemente er- die Installation von Zusatzhardware und damit die einfache Integration videospezifischer Funktionen. Hochwertige nonlineare Editingsysteme sind so gut ausgestattet, dass außer einem PC mit Zusatzhardware (Videoschnittkarte), großen Festplatten und dem Betriebssystem nur noch ein hochwertiger Massenspeicher, oft Recorder oder DVD-Brenner, vorhanden sein muss. Bei der Videoschnittkarte handelt es sich um integrierte oder zusätzliche im Computer installierte Hardware. Je nach Karte stehen digitale und analoge Ein-und Ausgänge zur Verfügung. Bei professionellen Systemen werden die zahlreichen Schnittstellen für Video, Audio und Referenzsignale meist über so genannte Break-Out-Boxen hergestellt, d. h. externe Gehäuse, die über spezielle Kabelverbindungen an die Videokarte angeschlossen werden. Das an der Videoschnittkarte anliegende Signal wird auf das Festplattensystem übertragen (digitales Filmmaterial) oder digitalisiert (bei analogem Filmmaterial). Den Vorgang des Übertragens oder Digitalisierens nennt man Capturing. Um die Videodaten zu verarbeiten, befinden sich auf einer Videokarte Prozessoren, die je nach Ausführung der Karte für die Kompression (Hardwarecodec) zuständig sind oder z. B. mehrere Videodatenströme gleichzeitig verarbeiten können. Hardwarecodecs sind die wichtigsten Bestandteile von Videokarten; dabei übernimmt ein Chip bzw. Prozessor, der eine Videokompression in Echtzeit beim Ein- oder Ausspielen der Videodaten bzw. -signale durchführt, die Verarbeitung. Diese Prozessoren entlasten den Hauptprozessor des Computers beim Videoschnitt. Aufwendigere Videokarten verfügen über Effektprozessoren für die Erzeugung von 2D- bzw. 3D-Effekten ohne notwendige Rendervorgänge oder digitale Videomixer für Echtzeitüberblendungen. Meist ist auch die entsprechende Audio-Hardware mit den notwendigen Anschlüssen auf der Karte integriert. Videoschnitt Software:

NLE-Systeme zeichnen sich durch die Benutzeroberfläche, die einfache Bedienbarkeit und umfangreicher Funktionen aus, die in der Software realisiert werden. Videoschnittkarten und Software werden als ein aufeinander abgestimmtes System (Bundel) zum Einbau in einem Standard-PC angeboten. Ebenso kann der Nutzer die Hard- und Software individuell zusammenstellen,

4 Grundlagen Technik 37

wobei die mögliche Leistung aufgrund nicht optimal kombinierter Systeme nicht erreicht wird. Die Schnittsoftware greift auf in dem Betriebssystem angebotenen Softwarecodecs zurück und man kann seine AV-Daten (audiovisuelle Daten) bearbeiten und ein- bzw. ausspielen.

4.4.1.2 Geschlossene nonlineare Schnittsysteme

Bei einem geschlossenen nonlinearen Schnittsystem handelt es sich um eine Kombination aus Soft- und Hardware, die so aufeinander abgestimmt sind, dass von außen her nicht mehr eingegriffen werden kann. Die Schnittsoftware ist speziell auf die Hardware zugeschnitten und nicht auf anderen Computerplattformen lauffähig.

Im oberen High-End-Bereich werden ausschließlich Komplettlösungen angebo- bei denen alle Hardwarekomponenten perfekt aufeinander abgestimmt sind. Diese Systeme laufen meist auf SGI (Silicon Graphics Incorporated) Plattformen und bieten die meisten Effekte und Bearbeitungsprozesse in Echtzeit an. [Schmidt03]

4.4.2 Audioschnitt

Videos werden zumeist mit Tönen, Geräuschen, Musik und gesprochenen Kommentaren ergänzt. Diese Daten werden in ein Audioschnittprogramm importiert, z. B. über ein Mikrofon, das CD-Laufwerk oder über den Line-In-Anschluss an der Soundkarte (siehe Kapitel 4.1). Bei der Aneinanderreihung von Audioaufnahmen gelten grundsätzlich ähnliche Prinzipien wie beim Video- schnitt. Es wird in erster Linie zwischen einem harten Übergang, einem Schnitt,

4 Grundlagen Technik 38

und einem weichen Übergang, einer Blende, unterschieden; dabei können zu- die vielfältigen Bearbeitungs- und Filtermöglichkeiten eingesetzt werden, um z. B. Hintergrundgeräusche herauszufiltern.

Mit der Audioschnittsoftware können die Audiodaten fertig vorbereitet werden, so dass sie im Videoschnittprogramm nur noch eingefügt und mit dem Bild synchronisiert werden müssen. [Rose04]

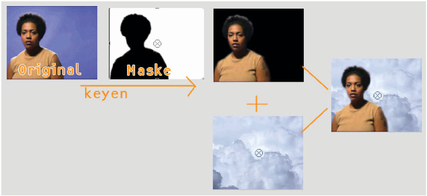

4.5 Bluescreen-Technik

Bluescreen-Technik bzw. -Verfahren ist ein Verfahren in der Film- bzw. Fernsehtechnik, das es ermöglicht, Gegenstände oder Personen nachträglich vor einen Hintergrund zu setzen, der beliebig gewählt werden kann.

Dabei wird das Objekt ohne Hintergrund vor einer gut ausgeleuchteten dunkel- Wand (Blue-Box) aufgenommen. Blau als Hintergrund wurde gewählt, weil es die am menschlichen Körper am seltensten vorkommende Farbe ist. Mittels eines Gelbfilters wird diese in der Aufnahme unterdrückt und gleichzeitig wird eine Aussparungs-Maske für einen getrennt aufgenommenen Hintergrund angefertigt. Beide Filme werden anschließend in einem Schnittsystem montiert. [Wiki06]

4 Grundlagen Technik 39

4.6.1 Lichttechnik

Die elektronische Kamera muss auf eine bestimmte Farbtemperatur eingestellt werden. Diese begründet sich in den unterschiedlichen Farbanteilen von Tageslicht, welches einen hohen Blauanteil hat, und Kunstlicht, welches einen hohen Rotanteil besitzt. Es besteht ein Zusammenhang zwischen der Farbtemperatur und dem weißen Licht. Die Farbtemperatur wird nach einer Temperaturskala, der Kelvinskala, gemessen. Kunstlicht kann sehr unterschiedliche Farbtemperaturen haben, wobei unter Kunstlicht jedes künstlich erzeugte Licht verstanden wird. Mischlicht entsteht im Freien bei blauem Himmel und tief stehender Sonne wie auch in Innenräumen, wenn Tageslicht und Kunstlicht zugleich in einem Bild auftreten. Man kann mit Korrekturfolien entweder das Tageslicht auf Kunstlicht oder das Kunstlicht auf Tageslicht konvertieren. Bei Camcordern muss man einen Weißabgleich durchführen, um die Farbe Weiß am Aufnahmeort zu definieren und deren Farbtemperatur festzulegen. Dabei hält man eine weiße Plastikkarte oder ein weißes Blatt Papier in den Bereich des Sets vor die Kamera, in welchem die bildwichtigen Personen oder Gegenstände sind. Bei einem automatischen Weißabgleich wird die in dem Ausschnitt hellste Stelle gesucht und als Weiß bestimmt, alle anderen Farben werden nun über dieses Weiß berechnet und definiert.

Trifft der Lichtstrom einer Lichtquelle auf eine Fläche, dann wird diese beleuchtet. Die Intensität, mit der dies geschieht, bezeichnet man als Beleuchtungsstärke und wird in Lux (lx) angegeben. In der Praxis empfiehlt sich die Messung der Lichtintensität, welche auch vom Reflexionsgrad des Hintergrundes und der Objekte abhängt, da das Auge als Schätzinstrument unbrauchbar ist. Häufig wird Tageslicht bei Außenaufnahmen mit Scheinwerfern oder Blenden unterstützt, um Schatten aufzuhellen. Dabei sind Scheinwerfer wichtig, die eine ähnliche Farbtemperatur wie Tageslicht besitzen. Am gebräuchlichsten sind HMI-Scheinwerfer. Kunstlicht-Scheinwerfer werden zwischen harten und weichen Scheinwerfern unterschieden, wobei hartes Licht von der Sonne oder einem Stufenlinsenscheinwerfer deutliche Schatten erzeugt und weiches Lichtvon Flächenleuchten oder Weichstrahlern einen diffusen Schatten wirft.

4 Grundlagen Technik 40

Die meisten professionellen Scheinwerfer verfügen über einen Mechanismus, der es ermöglicht, den Raumwinkel des ausströmenden Lichts und seine Intensität zu verändern. Je größer dieser Raumwinkel ist, desto geringer ist die Beleuchtungsstärke. [Ganslandt92]

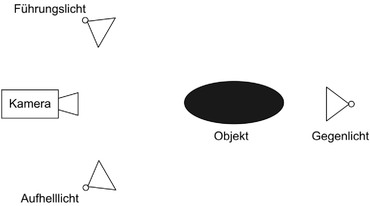

4.6.2 Lichtgestaltung

Die bewährten Gesetze der Lichtführung, mit denen auch schon vor 70 Jahren erfolgreich gearbeitet wurde, haben auch in der heutigen Zeit noch ihre Gültigkeit. Sie haben mit dem natürlichen Sehempfinden, mit der alltäglichen Erfahrung des Sonnenlichtes und kulturellen Gegebenheiten zu tun. Die grundlegenden Lichtquellen, die zum Einsatz kommen, sind Führungslicht, das Aufhelllicht und das Gegenlicht.

Das Führungslicht stellt die Hauptlichtquelle dar und besitzt die stärkste Leucht- Es sollte in der Strahlungsrichtung und Stärke der in der Szene erkennbaren Lichtquellen entsprechen (ähnlich einer virtuellen Sonne); das natürliche Szenenlicht wird sozusagen verstärkt. Nach ihm richten sich alle weiteren Lichtquellen. Je nach Einfallswinkel auf das Objekt wirft das Führungslicht Schlagschatten auf die Oberfläche.

- Arbeit zitieren

- MSc Michael Meister (Autor:in), 2006, Entwurf und Realisierung eines skalierbaren Multimedialabors aufbauend auf modernen didaktischen Konzepten, München, GRIN Verlag, https://www.grin.com/document/186214

Kostenlos Autor werden

Kommentare